Modulkatalog im Wahlpflichtbereich Informatik im Sommersemester

(unregelmäßig, im Sommersemester)

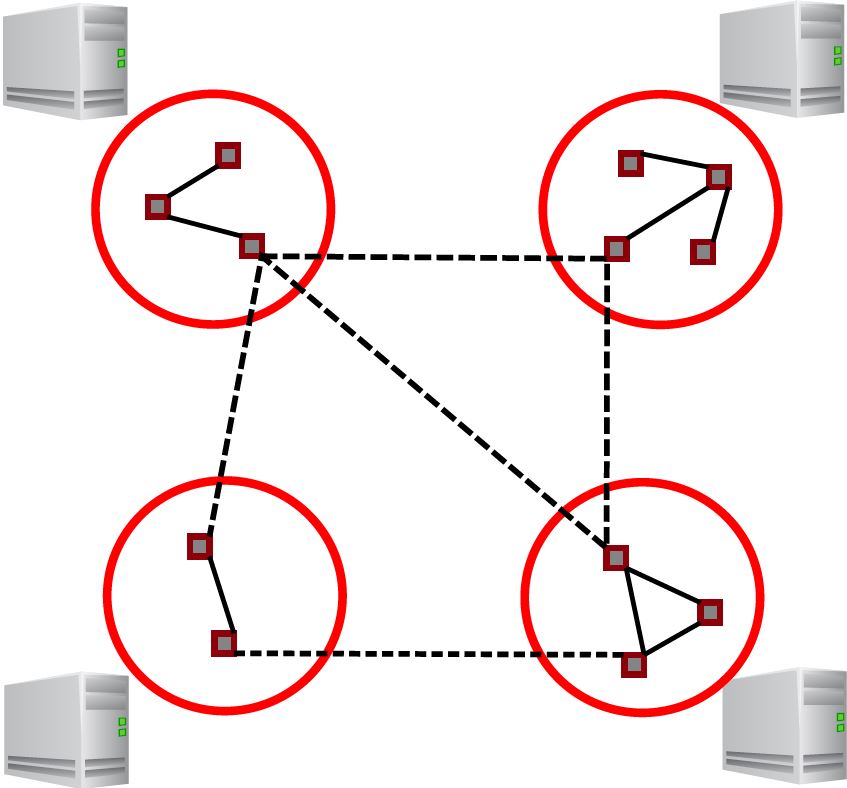

Parallel-verteilte Methoden zur Simulation spielen in den unterschiedlichsten Bereichen eine Rolle, in denen es gilt, große Systeme effizient zu simulieren, wie z.B. um Routingprotokolle in Computernetzwerken mit Millionen von Knoten auszuwerten, online den Flugzeugverkehr zu überwachen oder die Ausbreitung von Epidemien vorherzusagen. Im Modul werden Kenntnisse über parallel-verteilte Simulationsverfahren für diskret-ereignisorientierte Modelle vermittelt.

(unregelmäßig, im Sommersemester)

Das Modul behandelt Graphen- und Hypergraphenmodelle in einigen ausgewählten Gebieten der Informatik wie Bioinformatik, technischer und praktischer Informatik, Datenbanken und Künstlicher Intelligenz. Dazu werden grundlegende Eigenschaften und Methoden wie Baumstruktur von Graphen und Hypergraphen, Dekompositionsmethoden und Durchschnittsgraphen wie z.B. Intervallgraphen behandelt.

(unregelmäßig, im Sommersemester)

Eine Event-Driven Architecture (EDA) ist ein Architekturmuster, das auf der Erzeugung, Verteilung, Detektion und Verarbeitung von Ereignissen (engl.: Events) basiert. EDAs ermöglichen die lose Kopplung von Komponenten, Diensten und Prozessen, durch die auch große Systeme noch beherrschbar und skalierbar bleiben. Ursprünglich zunächst im Bereich der grafischen Benutzungsoberflächen verwendet, finden EDAs aufgrund ihrer Eigenschaften zunehmende und vielfältige Anwendungen. Die Veranstaltung stellt Ereignisse als zentrales Strukturierungsmittel vor und diskutiert die grundlegenden Ideen, Prinzipien und Konzepte darauf aufbauender Softwarearchitekturen. Sie gibt einen praxisbezogenen Einblick sowohl in die technologischen Grundlagen als auch in die praktische Umsetzung und Anwendung ereignisorientierter Architekturmuster.

(unregelmäßig,im Sommersemester)

Web 2.0 steht für dynamische, interaktive und kollaborative Anwendungen im Internet. Eine wichtige Ausprägung dieses "Mitmach-Gedankens" sind die sozialen Netze. Wir werden in dieser Veranstaltung viele der neueren Anwendungen im Web kennenlernen. Neben Technologien (Javascript, HTML5, kollaboratives Editieren) werden dabei auch wirtschaftliche Fragen (Business Cases) und strukturelle Aspekte (Blogs, Wikis, P2P Konzepte) im Fokus stehen.Die Vorlesung wird durch eine praktische Übung begleitet, in der im Team eine Web 2.0 Anwendung entwickelt wird.

(unregelmäßig,im Sommersemester)

Geschäftsprozesse finden statt. Indem wir sie modellieren, können wir sie besser verstehen und steuern. Wir lernen Modellierungssprachen kennen sowie Techniken zur Analyse, zum Betrieb und zum Mining von Geschäftsprozessen. Wir studieren Services, mit denen Geschäftsprozesse organisationsübergreifend strukturiert werden können.

(unregelmäßig,im Sommersemester)

Die Vorlesung gibt einen Überblick über die Methoden des Einsatzes von Strategien kooperierender Geräte- und Agentenensembles für die Steuerung intelligenter Umgebungen. Schwerpunkt der Vorlesung ist die Nutzung von Methoden aus der verteilten Künstlichen Intelligenz und des Semantic Web für die Steuerung intelligenter Umgebungen.

(unregelmäßig,im Sommersemester)

Sicherheit wird in allen Bereichen von IT-Anwendungen, speziell aber bei Mobilgeräten, in IoT (Internet of Things) Anwendungen und bei Gerätesteuerungen immer wichtiger. Die Vorlesung gibt einen Überblick über neuere Entwicklungen im Bereich Cyber-Sicherheit und stellt Anwendungen vor, die durch aktuelle Forschungsergebnisse der Kryptographie ermöglicht werden, darunter auch Blockchain und Crypto-Currency Technologien.

(unregelmäßig,im Sommersemester)

Warum sollte man eine Vorlesung mit dem üblen Titel "Theorie von etwas ansonsten doch Praktischen" besuchen? Um Techniken für Datenbanksysteme zu entwickeln oder gar Konzepte für zukünftige Informationssysteme zu erforschen, benötigt man Grundlagenwissen zu den Datenbankmodellen und -operationen. Für Masterarbeiten, Promotionsarbeiten, Veröffentlichungen, Projekte in Universitäten, Forschungsinstituten oder Forschungsabteilungen von IT-Unternehmen müssen nicht nur neue Techniken entwickelt und aufgeschrieben werden, sondern auch gezeigt werden, dass sie besser sind als bekannte, ältere Techniken. Wie modelliert man aber Problem und Aufgabenstellung? Wie vergleicht man mit bekannten Techniken? Wie schreibt man Techniken, Algorithmen sowie erreichte Eigenschaften von Techniken und Algorithmen auf? Wie weist man nach, dass die eigene Technik besser ist? Ein möglicher Nachweis ist der formale Beweis, indem man ein formales Modell entwickelt und einen formalen Nachweis der Eigenschaften führt. Für Entwicklungs- und Forschungsfragestellungen im Datenbankbereich werden in dieser Vorlesung die grundlegenden Techniken wie Schemaeigenschaften, Formalisierung von Integritätsbedingungen sowie die Formulierung von Datenbankanfragen und -optimierungsverfahren besprochen. Die theoretischen Grundlagen werden abschließend auf aktuelle Forschungsgebiete wie Anfrageoptimierung, Datenbankintegration, Schemaevolution und Updates auf Sichten angewendet.

(unregelmäßig,im Sommersemester)

Big Data Processing will focus on the following topics:

- Distributed and parallel databases: Data that was previously stored centrally is distributed horizontally and vertically to various computer nodes. The effects on design principles, transaction procedures, lock protocols and query optimization are explained.

- Parallel analysis of large amounts of data: Processing principles for the parallel analysis of distributed data are discussed, such as map/reduce and frameworks for data flow programming. Furthermore, it will be discussed how such analyses can be processed in a data-efficient and thus privacy-aware manner by means of vertical distribution of the algorithms.

- Data stream processing: When processing sensor data on the Internet of Things or in large-scale scientific experiments, new data is generated every second that has to be processed. Conventional database technologies are not suitable in such an environment. The lecture discusses concepts of streaming data management, which can filter, compress andanalyze data streams.

(unregelmäßig,im Sommersemester)

Das Modul besteht aus den Lehrveranstaltungen "Graphische Benutzungsoberflächen" und "Interaction Engineering".

Graphische Benutzungsoberflächen: Es werden technische, technologische und ergonomische Kenntnisse zur Erstellung, Gestaltung und Bewertung von graphischen Benutzungsoberflächen vermittelt, die von unterschiedlichen Wissenschaftsdisziplinen bereitgestellt werden.

Folgende Problemkreise werden insbesondere focussiert:

- Handlungsprozesse und Aspekte der Wahrnehmung,

- Normen und Standards der Softwareergonomie,

- Dialogtechniken, Entwurfsmuster und Metaphern,

- typische Elemente in Fenstersystembibliotheken.

Interaction Engineering: Interaktion erlaubt es Anwendern, Software zu bedienen und anzupassen. Mensch-Maschine-Interaktion folgt jedoch nicht dem typischen Schema Eingabe-Verarbeitung-Ausgabe, sondern erfordert andere Herangehensweisen. Die Lehrveranstaltung stellt grundlegende und erweiterte Konzepte für die Programmierung von Interaktion vor und zeigt, wie basierend auf diesen Konzepten interaktive Lösungen entwickelt werden können. Das Modul vermittelt darüber hinaus einen Überblick über verschiedene Interaktionstechniken sowie Frameworks zur Programmierung, die in Praktika angewandt werden.

(unregelmäßig,im Sommersemester)

This module deals with hardware and software aspects of Virtual and Augmented Reality. Students will develop a deep understanding topics related to virtual environments and interactive computer graphics. They will become familiar with current device technology as well as software design and application requirements for virtual environments. The following areas will be discussed:

- Human factors and perception

- Tracking technology and motion capture

- Display technology

- Spatial data structures

- Animation

- Augmented reality

- Telepresence

The lectures will be complemented with practical projects where students will be introduced to virtual reality system development.

(unregelmäßig,im Sommersemester)

(unregelmäßig,im Sommersemester)

Empirische Forschung und Evaluation sind Themen, über die viel gesprochen wird - oft allerdings ohne besondere Detailkenntnisse. Die wissenschaftlichen Methoden der empirischen Forschung und der Evaluation, die in den Human- und Sozialwissenschaften zu den Basismethoden der wissenschaftlichen Arbeit gehören, haben in der Informatik lange Zeit kaum eine Rolle gespielt.

In der Veranstaltung wird in die Grundlagen der empirischen Forschung aus der Perspektive der Informatik und am Beispiel von Softwaresystemen eingeführt. Betrachtet werden dabei der Methodenkatalog möglicher Untersuchung, die wissenschaftliche Hypothesenbildung, die Bedeutung und Auswahl von Stichproben oder Populationen, Verfahren wie statistische Hypothesenprüfung sowie quantitative und qualitative Methoden der Datenerhebung und die Datenauswertung.